Methoden und Verfahren

Visual Analytics

Hierbei handelt es sich um einen interdisziplinäreren Ansatz, der die Methoden der Visualisierung und der Mensch-Maschine-Interaktion mit Datenanalysen verbindet. Ziel ist es, Erkenntnisse aus extrem großen Datenmengen zu gewinnen, indem diese visuell aufbereitet werden, und somit Schlussfolgerungen durch den menschlichen Betrachter möglich zu machen.

Maschinelles Lernen

Dies ist eine Fachdisziplin der künstlichen Intelligenz. Es umfasst eine Reihe von Methoden, die zum Ziel haben, eine Maschine in die Lage zu versetzen, mit der Zeit eigenständig Objekte zu klassifizieren, Muster und Zusammenhänge zu erkennen sowie Prozesse zu optimieren. In der Regel werden Beispieldaten verwendet, um die Maschine zu trainieren und die Güte des gelernten Modells zu validieren.

(Künstliche) Neuronale Netzwerke

Es handelt sich dabei um eine Methode für maschinelles Lernen. Diese Algorithmen bilden die Vernetzungsstrukturen des menschlichen Gehirns (biologische Neuronen) und dessen Lernprozesse in abstrakter Weise nach : Künstliche neuronale Netzwerke bestehen aus einer Vielzahl sogenannter künstlicher Neuronen, die mit mathematisch beschriebenen Gewichtungsstärken miteinander verbunden sind. Während des Lernprozesses verändern sich diese Gewichtungen mit dem Ziel, einen möglichst fehlerfreien Output zu generieren.

Deduktion und constraint-basiertes Schließen durch Induktion und Abduktion

Diese Methoden können auf verschiedene Weise im Bereich Big Data zur Anwendung kommen. Deduktives Schließen wird in Inferenzsystemen (das heißt Systemen, die Regeln und Fakten über ein Fachgebiet enthalten, an denen eingegebene Informationen gemessen werden) eingesetzt, um semantische Zusammenhänge in großen Datenmengen zu erkennen. In constraint-basierten Ansätzen wird darauf abgezielt, neue Hypothesen für große Datenmengen zu finden. Hierbei kann man entweder Hypothesen aufstellen und diese in den vorhandenen Daten nachzuweisen versuchen oder umgekehrt, von Beobachtungen ausgehend generalisieren.

Informationsextraktion und Text Mining

Sie umfassen Techniken, die sich mit der Vorverarbeitung großer Datenmengen beschäftigen. Insbesondere bei der semantischen (bedeutungsmäßigen) Analyse von menschlicher Sprache oder großvolumigen Textinhalten kommen solche Methoden zum Einsatz. Ziel ist es, Terminologien und Ontologien (Darstellungen von Mengen an Daten und zwischen ihnen bestehenden Beziehungen) zu finden und für weiterführende Analysen nutzbar zu machen.

Analytische Architekturen

Sie sind ein wesentlicher Bestandteil von Big-Data-Technologien, da sie die Grundlage für das Verarbeiten der Daten bilden. Analytische Architekturen sind Plattformen, mit denen das Entgegennehmen, die Speicherung und Ausgabe von großen Datenmengen überhaupt erst ermöglicht werden.

Übersicht zu Methoden und möglichen Einsatzbereichen

|

Big Data Methode |

Einsatzbereich / Nutzen |

|

Visual Analytics |

Besonders geeignet, wenn ein Gesamtbild gezeichnet werden soll (z. B. von Prozessen im Unternehmen) ; einfache / intuitive, interaktive Darstellung der Ergebnisse |

|

Maschinelles Lernen |

Mustererkennung – zum Beispiel für vorausschauende Wartung oder Analyse von menschlicher Kommunikation für die Optimierung der Kundenschnittstelle |

|

Neuronale Netzwerke |

Automatisierte Mustererkennung in Daten und Ableitung bisher nicht erschließbarer Muster aus der Struktur der Daten; der Einsatz ist auch möglich, wenn im Vorfeld keine festen Gesetzmäßigkeiten in den Datensätzen bekannt sind – etwa bei der Gesichtserkennung |

|

Deduktion, Induktion, Abduktion |

Aufdecken von Regeln, Aufstellen und Testen von Hypothesen |

|

Informationsextraktion, Text Mining |

Rückschlüsse aus Daten ziehen, gemeinsame Eigenschaften und Widersprüche erkennen, fehlendes Wissen selbstständig aus dem vorhandenen ergänzen |

|

Analytische Architekturen |

Parallele Bearbeitung enormer, auch unstrukturierter Datenmengen – unter anderem für die Bewältigung zahlreicher gleichzeitiger Lese- und Schreibanfragen |

Eigene Darstellung, basierend auf Prognos / Heckmann, 2016

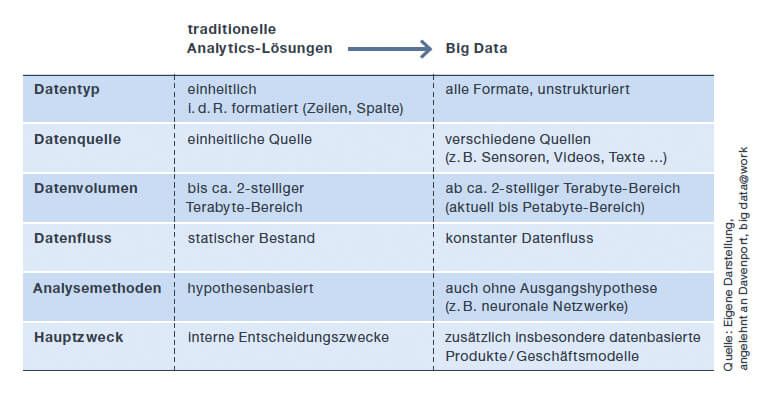

Die mit dem Begriff Big Data verbundenen Technologien und Anwendungen bieten Grundlagen für einen erheblichen wissenschaftlichen und technologischen Fortschritt. Sie ermöglichen es, aus der Analyse und Zusammenführung einer Vielzahl von heterogenen, umfangreichen und teilweise unstrukturierten Datenbeständen neue Informationen, Strukturen, Zusammenhänge, Modelle und Einsichten zu generieren.